Augmented Reality

Augmented Reality: component inschakelen voor effectieve live virtuele constructieve integratie

Auteurs:

Frank Dean — Hoofdonderzoeker

Simulation & Training Technology Center, US Army RDECOM

12423 Onderzoek Parkway

Orlando, FL 32826-3276

Frank.Dean@us.army.mil

Sheila Jaszlics — Voorzitter

Richard Stilson — Ingenieur

Scot Sanders - Ingenieur

Pathfinder Systems, Inc.

5525 West 56th Ave, Suite 400

Arvada, CO 80002-2804

sheila@snakephotographer.com

rstilson@snakephotographer.com

ssanders@snakephotographer.com

Abstract

Dit artikel beschrijft de resultaten van een RDECOM-onderzoeksproject genaamd het Dismounted Augmented Reality Training System (DARTS). Het DARTS-prototype dat in het kader van deze inspanning is ontwikkeld, biedt bemoedigende gegevens en het vertrouwen dat de tools en technieken die nodig zijn om deze technologie in een live militaire trainingsomgeving te implementeren, niet ver weg zijn. Uiteindelijk is de sleutel tot succesvolle implementatie en gebruik van deze opkomende technologie dat trainers het potentiële gebruik ervan begrijpen en de nadruk leggen op verdere ontwikkeling voor specifieke militaire toepassingen.

Invoering

Stelt u zich eens voor dat de Warfighter een effectieve ingebouwde mogelijkheid heeft om overal en altijd te trainen zonder langdurige voorbereiding. Gezien de hoeveelheid tijd en fiscale middelen die in verschillende soorten militaire opleidingssystemen zijn geïnvesteerd, zou een van de meest efficiënte manieren om een dergelijk doel te bereiken zijn om bestaande en geplande systemen samen te voegen tot een grotere geïntegreerde omgeving. Met andere woorden, vervaag de lijnen of grenzen, zowel fysiek als mentaal, die de Warfighter-training scheiden in de discrete live, virtuele en constructieve trainingsomgevingen die we tegenwoordig gebruiken.

Met een dergelijke mogelijkheid kunnen trainers de juiste en beschikbare systemen mix-matchen of plug-playen om aan de juiste trainingsdoelen te voldoen. In deze zin is een van de belangrijkste interessegebieden van de legertrainingsgemeenschap het implementeren van live, virtuele en constructieve integratie. Helaas is er vanuit het huidige LVC-IA-perspectief geen tweerichtingsverkeer en presentatie van trainingsgegevens tussen het live trainingsdomein en de virtueel-constructieve trainingsdomeinen. Lopende LVC-onderzoeks- en acquisitie-inspanningen zijn voornamelijk gericht op de overdracht van de positiegegevens van de live deelnemers naar het virtuele domein voor weergave en interactie. Live deelnemers kunnen echter de realtime weergave van personeel, voertuigen, vuur en effecten, enz. die afkomstig zijn uit het virtuele domein niet "zien". Met het oog op een effectieve "Train the Force, How and As It Fights!" er moet een volledige replicatie zijn van complexe besturingsomgevingen. Voor een waarheidsgetrouwer beeld van complexe besturingsomgevingen moet er volledige integratie zijn: een tweerichtingsverkeer voor gegevensstroom over de trainingsdomeinen. Als de gegevens- en informatiestroom slechts in één richting gaat, dan is en kan de architectuur niet "volledig geïntegreerd" worden verklaard.

Als het nieuwe paradigma van transformatie in training, hoe zou een LVC geïntegreerde complexe trainingsomgeving eruit zien? Beeld het volgende scenario in:

Leden van een kleine eenheid zijn bezig met een live trainingsoefening in Ft. Lewis, WA of Ft. Kap, TX. Tijdens de oefening is er een oproep voor close air support, die wordt geleverd door een piloot die in opleiding is in een luchtvaart gecombineerde wapentrainer, gevestigd in Ft. Rucker, AL of Ft. Bragg, NC. Bij de nadering om luchtsteun te bieden, bieden de monitors van de piloot een geïntegreerd beeld van de gevechtsruimte, inclusief pictogrammen/avatars die de gevolgde posities van de kleine eenheidsleden vertegenwoordigen. Terwijl hij in de virtuele omgeving werkt, kan de piloot de kleine eenheidsleden zien; de kleine eenheid die in de live-omgeving werkt, is echter niet in staat om de acties van de piloot te zien en erop te reageren, zonder enige tussenkomst van misschien een waarnemer-controller (OC). Een werkelijk geïntegreerde complexe omgeving zou de kleine eenheid die op de grond opereert in staat stellen op zijn minst het vliegtuig en eventuele brand en effecten als gevolg van de missie van de piloot te observeren. Momenteel gebeurt dat niet. Welke technologieën kunnen worden ontwikkeld en toegepast om een effectiever geïntegreerde opleidingsomgeving en capaciteit voor dit en soortgelijke scenario's te bieden? Is er een oplossing die beschikbaar zou kunnen zijn waarmee een gemonteerde of gedemonteerde Warfighter, die in de live-omgeving opereert, kan "zien" en "interactie" met degenen die virtueel of constructief opereren? Het antwoord is ja!" De oplossing is Augmented Reality.

Live virtuele constructief geïntegreerde architectuur (LVC-IA)

(Informatie afkomstig van Project Manager voor Future Force (simulatie))

LVC-IA-concept

De LVC-IA integreert huidige en toekomstige live, virtuele en constructieve simulatiesystemen om gevechtscommandosystemen te stimuleren voor missieplanning, repetitie en training. LVC-IA biedt dus een geïntegreerde LVC-trainingsomgeving die de beschikbare gevechtsruimte uitbreidt, terwijl de trainingsomgeving de operationele omgeving beter benadert. Een geïntegreerde LVC-omgeving maakt on-demand, gedistribueerde missieplanning, repetities en training mogelijk die nodig zijn om vaardigheid te verwerven en te behouden op het gebied van bewustzijn van gevechtsruimte, krachttoepassing, gerichte logistiek en bescherming.

LVC-IA-abonnement

Implementeer een gestandaardiseerde set protocollen, specificaties en standaarden die interoperabiliteit en integratie tussen Army & Joint LVC-componenten mogelijk maken.

Bied een geïntegreerde LVC-omgeving die zorgt voor compatibiliteit en interoperabiliteit voor alle TADSS en die volledig is geïntegreerd in het Future Force Battle Command-systeem, terwijl het gekoppeld is aan en het Joint Command and Control (JC2) -systemen stimuleert.

Bied Plug-and-Train-mogelijkheden ter ondersteuning van operaties, missieplanning-repetitie, op aanvraag, altijd en overal, terwijl u in een gezamenlijke context traint.

Maakt interoperabiliteit en integratie tussen a. Gezamenlijke familie van simulaties (JFOM) & (JNTC-inspanningen). B. Gemeenschappelijke Training Instrumentatie Architectuur (CTIA). C. Synthetische Omgeving (SE) Kern. NS. Leger Constructieve Training Federatie (ACTF). e. Test en Training Enabling Architecture (TENA). F. Andere potentiële LVC-componenten (FCS FoS, WIN-T?). G. Integreert in en stimuleert JC2.

Augmented Reality

Wat is Augmented Reality (AR)? AR-technieken verbeteren het livebeeld van de Warfighter van de complexe trainingsomgeving door in realtime tekst, afbeeldingen, 2D/3D-objecten en andere informatie te leveren. Zo biedt AR de Warfighter, die in de live-omgeving werkt, een groter bewustzijn van de effecten van overlappende virtuele en constructieve trainingssimulaties. Deze rekenintensieve manier om live en virtuele entiteiten samen te voegen tot één naadloos geïntegreerd beeld van de gevechtsruimte, kan commandanten en trainers de mogelijkheid bieden om live-virtueel-constructieve trainingsmissies te mixen, evenals verschillende trainingseffecten in verschillende omgevingen te coördineren en te integreren. Op de juiste manier gebruikt, kan AR het realisme en de effectiviteit van live training vergroten, van zowel gemonteerde als gedemonteerde prospects, terwijl het versmelt met de virtuele en constructieve trainingsdomeinen.

Hoewel het Amerikaanse leger op dit moment geen definitieve vereiste heeft voor het gebruik van Augmented Reality, suggereert recent onderzoek dat is uitgevoerd door het Simulation & Training Technology Center (STTC), Research, Development & Engineering Command (RDECOM), Orlando, Florida dat Augmented Reality kan worden gebruikt in een breed scala aan legertrainingstoepassingen. Het concept van Augmented Live Environments heeft het potentieel om interactieve, multi-zintuiglijke, niet-lineaire omgevingen te creëren die de Warfighter ongeëvenaarde en realistische live training en ervaringsgericht leren bieden. Een dergelijke capaciteit zou commandanten en trainers mogelijk kunnen voorzien van creatieve en flexibele oplossingen voor de steeds veranderende en fluctuerende missies en trainingsvereisten van de moderne Warfighter.

Wat zijn de technologische uitdagingen bij het bieden van Augmented Reality-mogelijkheden aan de Warfighter? Deze vraag kan het beste worden beantwoord door recent onderzoek te onderzoeken. Het Dismounted Augmented Reality Training System (DARTS) is een door RDECOM gefinancierd project van het Amerikaanse leger dat onderzoek wilde doen naar AR-technologiekwesties. DARTS is oorspronkelijk gestart onder de Embedded Technology Dismounted Soldiers, Science & Technology Objective (ETDS STO), die eindigde in de herfst van 2004. Aanvullend DARTS-werk werd gefinancierd en voortgezet onder de Embedded Combined Arms Team Training, Army Technology Objective (ECATT ATO) en culmineerde met een technologiedemonstratie in december 2005.

Ondanks beperkte financiering heeft Pathfinder Systems, Inc een moeilijk probleem aangepakt - realtime, tether-less, door mensen draagbare Augmented Reality - en heeft een ontwikkelingsprototype ontworpen, dat in december 2005 werd gedemonstreerd. Hoewel de financieringsbeperkingen vertraging hebben opgelopen extra werk op dit gebied, een aantal problemen en waardevolle informatie werden geïdentificeerd voor toekomstige analyse en onderzoek. De rest van dit artikel beschrijft de resultaten van dit onderzoek.

Gedemonteerd Augmented Reality Training Systeem (DARTS)

Het doel van de DARTS-inspanning was om aan te tonen dat het mogelijk is om een werkend Augmented Reality (AR)-systeem te ontwikkelen dat in realtime kan werken, met behulp van een compacte, niet-opdringerige uitrusting die door een oorlogsjager wordt gedragen. Ons doel was om ons AR-systeem te laten werken in een omgeving die niet vooraf was onderzocht, geïnstrumenteerd of anderszins voorbereid om te kunnen werken. Eerdere AR-systemen konden niet in realtime werken, of ze vereisten het gebruik van een uitgebreide niet-mobiele infrastructuur. Veel AR-systemen vereisen het gebruik van een complex raster van vooraf gemeten markeerpunten om te kunnen werken. Het is duidelijk dat AR die een dergelijke aanzienlijke voorbewerking van de omgeving vereist, niet de meest wenselijke technologische oplossing is voor de snelle, live of ingebedde militaire trainingstoepassingen.

Het doel van het DARTS AR-systeem was om virtuele objecten (in dit geval een virtuele Infantry Combat Vehicle of ICV) in het gezichtsveld van een gebruiker te plaatsen door middel van een doorzichtige head-mounted display (HMD). Het virtuele object moet in het gezichtsveld van de gebruiker worden geplaatst, zodat het lijkt alsof het een echt object is met een fysieke locatie in de echte wereld. Aangezien het virtuele object eigenlijk slechts een projectie in de HMD is, moet de weergegeven positie van het virtuele object meebewegen als de gebruiker zijn hoofd beweegt, zodat het lijkt alsof het virtuele object op een echte locatie is vastgezet. De gebruiker moet in staat zijn om naar de ICV te lopen en deze groter te zien worden naarmate hij dichterbij komt. Evenzo moet de gebruiker in staat zijn om rond de ICV te lopen en de voor-, achterkant of zijkanten vanuit verschillende hoeken te bekijken. Ten slotte, als een echt object, zoals een struik of een andere persoon, tussen de AR-gebruiker en de tank komt, mag het deel van de ICV dat aan het zicht zou worden onttrokken, niet worden weergegeven. Al deze doelen zijn tot op zekere hoogte bereikt door eerdere AR-onderzoeksinspanningen, maar ze zijn niet in realtime gedaan, met behulp van een door de mens gedragen systeem dat in een onvoorbereide omgeving werkt.

Bij onze inspanningen moesten we ook de mogelijkheid demonstreren om nuttige AR-inhoud in het gezichtsveld van een gebruiker in te voegen, op een manier die kan bijdragen aan militaire training en operaties. Dit kan het weergeven van situationeel bewustzijnsgegevens in de vorm van objectcontouren of markeringspictogrammen zijn. Het kan een AR-systeemgebruiker ook in staat stellen deel te nemen aan een simulatie, zodat eenheden van een simulatietraining worden weergegeven als virtuele objecten waarmee de gebruiker kan communiceren. Met deze algemene doelen in gedachten hebben we een reeks vereisten voor de basisinspanning opgesteld. De specifieke doelen van deze basisinspanning waren:

Injecteer virtuele entiteiten in een real-time scène in de echte wereld

Geschikt voor objecten uit de echte wereld die het zicht op een virtueel object blokkeren

Integreer een gesimuleerd infanteriegevechtsvoertuig (ICV) in de weergave van de gebruiker

Demonstreer een tweerichtingsinterface met Distributed Interactive Simulation (DIS)-protocol met RDECOM's Infantry Combat Vehicle Testbed van het Amerikaanse leger

Demonstreer het vermogen om een door de mens gedragen, niet-verbonden AR-systeem te bedienen

Deze doelen zijn hieronder grafisch weergegeven:

Prestaties van het DARTS-programma

Onze DARTS-demonstratie, gehouden in december 2005, was succesvol. We waren in staat om een door de mens gedragen AR-systeem te demonstreren waarmee een DARTS-gebruiker kon communiceren met een virtuele ICV die werd gepresenteerd in de DARTS HMD. De gebruiker kon de virtuele ICV vanuit verschillende gezichtspunten bekijken in de real-world, real-time omgeving. De DARTS-gebruiker kon de virtuele ICV ook zien bewegen in de real-world, real-time omgeving. Een samenvatting van de componenten die ons hebben geholpen om deze prestatie te realiseren, worden hier samengevat:

Tweerichtings-DIS-interface: We hebben software ontwikkeld om DIS Protocol Data Units (PDU's) van een netwerkverbinding te ontvangen en te decoderen, en ook om DIS PDU's te coderen en te verzenden. We hebben code ontwikkeld om de positie en oriëntatie van de entiteit tussen het wereldcoördinatenframe dat door het ICV-testbed wordt gebruikt, om te zetten in een lokaal coördinatenframe dat door DARTS wordt gebruikt.

Virtual Entity Control: We hebben onze DIS PDU-communicatiesoftware geïntegreerd in DARTS, zodat we de positie- en oriëntatiecoördinaten van een inkomende PDU konden gebruiken om de positie van een virtueel object ten opzichte van de DARTS-entiteit te bepalen. We hebben ook code ontwikkeld om de lokale positie van de DARTS-entiteit om te zetten in wereldcoördinaten en die coördinaten naar een uitgaande DIS PDU te sturen. We ontwikkelden en demonstreerden een eerste DIS-interface met de ICV-simulator waarmee virtuele en live entiteiten met elkaar konden communiceren en een gedemonteerde gebruiker een virtuele entiteit in een real-world, realtime weergave kon zien.

Draadloze positiebepaling: we hebben software ontwikkeld om toegang te krijgen tot het Ubisense draadloze positievolgsysteem en meerdere keren per seconde positie-updates te verkrijgen. Deze positiegegevens worden gebruikt om het DARTS-systeem te laten bepalen waar het zich ten opzichte van de wereld bevindt, zodat we kunnen bepalen hoe een virtuele entiteit in het DARTS-systeem moet worden weergegeven en hoe de DARTS-gebruiker moet worden weergegeven in de virtuele wereld van het ICV Testbed verschijnt. Deze mogelijkheid werd gebruikt om vroege demonstraties mogelijk te maken, terwijl we onze objectieve puntvolg- en pose-herstelalgoritmen ontwikkelen waarvoor geen extra infrastructuur nodig is naast de uitrusting die door de soldaat wordt gedragen. Deze nieuwe pose-herstelalgoritmen zullen uiteindelijk de positioneringsgegevens vervangen die door het UbiSense-systeem worden geleverd (naarmate er geld beschikbaar komt om dit onderzoek voort te zetten). Het UbiSense-systeem wordt ook gebruikt voor DARTS-systeemtests om de nauwkeurigheid van onze poseherstelalgoritmen te valideren.

Op OLED gebaseerde HMD: we hebben een monoculaire HMD op OLED-basis in het systeem geïntegreerd om het nut van de OLED-schermen te verifiëren ter ondersteuning van gedemonteerde training. De HMD zorgde voor voldoende getrouwheid in een monoculaire weergave. We konden samenwerken met op OLED gebaseerde HMD-fabrikanten zoals Liteye en ICUITI om een conceptueel ontwerp voor een verrekijkersysteem te ontwikkelen. Op dit moment biedt OLED-technologie het beste potentieel voor de ontwikkeling van HMD-oplossingen die voldoende zijn om gedemonteerde training te ondersteunen en goedkoop genoeg om te worden gekocht in de grote hoeveelheden die nodig zouden zijn als deze trainingstechnologie door het Amerikaanse leger zou worden aangenomen.

Draadloos tv-transmissiesysteem voor demonstratie-ondersteuning: we hebben verschillende beeldtransmissiesystemen geëvalueerd en verschillende optionele systemen geïmplementeerd om het beeld dat voor de DARTS-gebruiker wordt geproduceerd, beschikbaar te maken voor andere waarnemers in de buurt.

Ontwikkeling van algoritmen voor het volgen van punten en poseherstel: we hebben een algoritme voor het volgen van punten geïmplementeerd met behulp van de MATLAB-softwareomgeving die punten kan volgen via een reeks afbeeldingen. Dit algoritme vindt punten uit verschillende delen van het videobeeld, met behulp van een algoritme dat gemakkelijk te volgen punten identificeert. Zodra het algoritme deze gemakkelijk te volgen punten identificeert, zoekt het naar een overeenkomst voor elk van deze punten in opeenvolgende afbeeldingen. Deze punten worden gebruikt om de positie en oriëntatie van de DARTS-gebruiker te bepalen ten opzichte van echte objecten en virtuele entiteiten in de omgeving. We hadden gehoopt het verbeterde algoritme in deze fase te integreren, maar konden dit niet doen vanwege de moeite die het kostte om het algoritme te maken. We konden het algoritme echter demonstreren en valideren met behulp van videoclips die waren verkregen van de STTC-demonstratiesite. De volgende paragrafen geven een overzicht van het pose-tracking-algoritme dat voor deze inspanning is ontwikkeld.

Om een virtueel object weer te geven zodat het de echte wereld correct overlapt, moeten we een zeer nauwkeurige schatting hebben van de richting waarin de helm wijst. We moeten dit van moment tot moment volgen terwijl de DARTS-gebruiker zich verplaatst, en dit met de grootst mogelijke precisie. Als het hoofd van de gebruiker niet precies wordt gevolgd terwijl het beweegt, lijkt het alsof het virtuele object op een onrealistische manier tegen de echte wereld in beweegt. Bovendien kunnen kleine positiefouten zich ophopen totdat het systeem volledig verloren is. Als een virtueel object bijvoorbeeld precies 10 meter ten zuiden van de positie van de gebruiker zou moeten zijn, dan zou dat object gecentreerd moeten zijn in het gezichtsveld van de gebruiker als de gebruiker naar het zuiden kijkt. Als het systeem de oriëntatie van de gebruiker uit het oog verliest, kan het het object niet weergeven wanneer de gebruiker in de juiste richting kijkt. In plaats daarvan kan het object naar het oosten of het westen worden weergegeven. Het kan er zelfs voor zorgen dat het lijkt alsof het virtuele object rond de gebruiker draait.

Voor onze basisinspanning hebben we een draadloze positiesensor en een traagheidspositiesensor gebruikt om de positie en oriëntatie van de DARTS-helm te volgen. Deze sensoren leveren redelijk nauwkeurige gegevens, maar ze hebben niet de precisie die nodig is om een zeer realistische positionering van virtuele objecten tegen een echte wereldscène mogelijk te maken. Naast het gebrek aan precisie had elke sensor zwakke punten waardoor ze onder bepaalde omstandigheden valse gegevens konden verstrekken. Ons doel is om het stereovisiesysteem te gebruiken om de positie van de helm beter te kunnen volgen, door de verandering in de videobeelden te meten terwijl de helm beweegt, en vervolgens de stereovisie-trackinggegevens te combineren met de andere sensorgegevens om de beste schatting van de positie van de helm die we kunnen.

Een mens die naar een videobeeld kijkt, kan intuïtief de beweging van de videocamera bepalen aan de hand van de manier waarop de videobeelden bewegen. Als de camera bijvoorbeeld naar rechts draait, verwachten we dat objecten in het videobeeld naar links bewegen. Als de camera naar voren beweegt, zullen objecten in het midden van het beeld groter worden, en objecten aan de boven-, onderkant of zijkanten van het beeld zullen weg van het midden en naar de rand van het beeld bewegen. Als we de camera ondersteboven draaien, draait het beeld ook ondersteboven. Als we een computerprogramma gebruiken om punten in een videobeeldreeks te volgen, en stereovisie gebruiken om de 3D-positie van deze punten ten opzichte van de bewegende camera te berekenen, dan kunnen we de puntvolginformatie gebruiken om de beweging van de camera te berekenen, net zoals een mens dat intuïtief doet. Als we deze volgpunten kunnen volgen en hun positie met een hoge mate van precisie en nauwkeurigheid kunnen bepalen, dan kunnen we de positie van de helm ook met een hogere precisie en nauwkeurigheid volgen dan mogelijk is met onze traagheidssensor of onze draadloze positiesensor .

Om de positie van een punt ten opzichte van een bewegende camera te volgen, moeten we een paar stereocamera's gebruiken en het punt in beide camerabeelden volgen. Eerst moeten we het punt tussen de linker- en rechterafbeelding matchen, zodat we de positie van het punt kunnen bepalen, dan moeten we dat punt volgen door een beeldreeks van beide camera's, zodat we de beweging van het punt kunnen bepalen. Over het algemeen is het voor een computerprogramma niet eenvoudig om overeenkomende punten in een paar afbeeldingen te vinden, maar sommige punten zijn gemakkelijker te volgen dan andere. Om het beste algoritme voor het volgen van punten te ontwikkelen, hebben we een manier nodig om punten te identificeren die gemakkelijk te volgen zijn, en we hebben een manier nodig om valse overeenkomsten zoveel mogelijk te elimineren, terwijl we goede punten zo lang mogelijk volgen.

We matchen punten door het gebied rond een punt in elke afbeelding te vergelijken en hun overeenkomst te berekenen. Als het gebied rond een punt in de ene afbeelding bijna identiek is aan het gebied rond het punt van de andere afbeelding, kunnen we concluderen dat de punten overeenkomen. Als we er zeker van willen zijn dat we alleen de beste overeenkomsten gebruiken voor het bijhouden van punten, kunnen we alleen overeenkomsten accepteren met de beste overeenkomstenscores. Deze benadering geeft ons echter niet de mogelijkheid om punten te volgen door een lange reeks afbeeldingen terwijl de camera beweegt, en het geeft ons geen goed vermogen om punten te herkennen die we al eerder hebben gevolgd. Terwijl de camera beweegt, verandert het uiterlijk van een volgpunt. Het gebied rond een punt kan groter worden naarmate de camera ernaartoe beweegt, of het gebied rond een punt kan roteren als de camera wordt gedraaid. Eenvoudige algoritmen voor het matchen van punten kunnen geen rekening houden met dit soort wijzigingen, dus laten ze een lagere overeenkomstscore zien, waardoor het punt wordt afgewezen. We hebben een manier nodig om een punt te herkennen dat we hebben gevolgd, zelfs als we het vanuit een andere hoek zien, zodat we goede punten kunnen volgen zolang ze in het zicht blijven, en eerder gevolgde punten herkennen als ze weer in beeld komen. Als we dit niveau van punttracking op lange termijn kunnen bereiken, kunnen we de positie van de DARTS-helm gedurende langere tijd nauwkeurig volgen. Ons doel is om een verscheidenheid aan geavanceerde beeldverwerkingstechnieken te combineren om dit soort puntvolging te bereiken.

We hebben verschillende testprogramma's ontwikkeld die ons naar dit doel brengen. De eerste stap is om punten te herkennen wanneer ze vanuit verschillende hoeken worden bekeken. Als we bijvoorbeeld beginnen met het volgen van een punt en het volgen door een bewegende reeks van 100 afbeeldingen, willen we het punt van de laatste afbeelding kunnen vergelijken en zien dat het nog steeds overeenkomt met het punt van de eerste afbeelding. Een beeldverwerkingstechniek die een affiene transformatie wordt genoemd, kan de verandering in het uiterlijk van een punt modelleren wanneer het vanuit verschillende hoeken wordt bekeken. Als we een affiene transformatie kunnen vinden die het startpunt verandert zodat het eruitziet zoals het zou zijn vanuit de uiteindelijke kijkhoek, dan zouden de punten er hetzelfde uit moeten zien. Wanneer we de overeenkomst tussen het getransformeerde beginpunt en het eindpunt berekenen, zouden we een zeer goede matchscore moeten kunnen krijgen, die we niet zouden kunnen krijgen zonder de affiene transformatie toe te passen. We hebben een programma ontwikkeld dat deze techniek toepast en gebruikt om een aantal punten door een reeks beelden van één camera te volgen.

Naast het volgen van punten door een reeks afbeeldingen, moeten we ook de punten tussen de linker- en rechtercamera matchen. Hiermee kunnen we de afstand en hoek van de camera tot het punt bepalen. Naarmate de camera beweegt, veranderen deze afstand en hoek. Door de verandering in afstand en hoek van een aantal punten te meten, kunnen we de beweging van de camera berekenen. We hebben code ontwikkeld die punten tussen een linker- en rechtercamera matcht en die punten vervolgens van de ene afbeelding naar de andere volgt.

We zullen de functionaliteit van het positievolgprogramma combineren met de functionaliteit van het programma dat veranderingen in de kijkhoek compenseert. Zodra we deze programma's combineren, hebben we een goede initiële mogelijkheid om punten over een aantal frames te volgen. In de volgende stap zullen Kalman-filters worden ontwikkeld die de ruisgegevens die we ontvangen van de draadloze positietracker, de traagheidspositietracker en het puntvolgsysteem zullen verfijnen. Elke lezing van elke gegevensbron zal de neiging hebben om enige fout te bevatten, en elke gegevensbron zal enigszins afwijken van de andere gegevensbronnen. Een Kalman-filter is een techniek om gegevens met ruis uit meerdere gegevensbronnen te combineren om een optimale schatting te geven van de gemeten waarde. In ons geval geeft het Kalman-filter een optimale schatting van de positie en oriëntatie van de DARTS-helm, met nieuwe bijgewerkte schattingen bij elke nieuwe sensormeting. Het gecombineerde systeem, met verbeterde punttracking van stereovisie en Kalman-filtering om meerdere gegevensbronnen te combineren en glad te strijken, zal de prestaties van het DARTS-systeem aanzienlijk verbeteren.

Samenvatting van de bevindingen voor het DARTS-programma

Hier vatten we de belangrijkste bevindingen van deze inspanning samen:

We hebben geconstateerd dat draagbare, gedemonteerde AR haalbaar is

We waren in staat om de omgeving rond de AR-gebruiker te voelen om de gegevens te verzamelen die nodig zijn om virtuele objecten correct weer te geven

We demonstreerden realtime occultatie van virtuele objecten (virtueel en dynamisch) door echte objecten

We waren in staat om een virtueel object correct weer te geven terwijl de gebruiker in positie en oriëntatie rond het virtuele object bewoog

We waren in staat om tegemoet te komen aan de verwerkings- en stroombehoeften van het systeem in een door de mens gedragen configuratie

Efficiënte software kan AR in staat stellen om succesvol te werken met verminderde verwerkingsvereisten om realtime werking mogelijk te maken zonder overmatige apparatuurvereisten

Stereovisiegegevens kunnen worden gebruikt om de nodige omgevingsgegevens te verzamelen.

Geavanceerde computervisietechnieken kunnen zorgen voor een grotere getrouwheid van stereovisiegegevens

Verbetering van het hardware-ontwerp voor DARTS is nodig om het gebruiksgemak van het systeem te vergroten

DARTS zal in de nabije toekomst kunnen werken op draagbare computersystemen zoals de Quantum 3D Thermite

See-Through Head Mounted Displays, waarschijnlijk gebaseerd op OLED-technologie, zullen in de nabije toekomst een acceptabel niveau van zichtbaarheid en detail bieden

Een herbruikbare software-architectuur kan worden aangepast en hergebruikt met verschillende sensorsuites, afhankelijk van de toepassingsklasse (wapen, voertuig, door de mens gedragen systeem)

Augmented Reality aan het werk voor de Warfighter

De volgende paar afbeeldingen zijn misschien wel de beste manier om het potentieel van AR voor de Warfighter te laten zien:

Injecteer virtuele entiteiten in real-time scènes in de echte wereld

Geschikt voor objecten uit de echte wereld

Infanterie Gevechtsvoertuig (ICV) Testbed

Ongebonden, door de mens gedragen AR-mogelijkheid

Prestaties van het DARTS-programma

Onze DARTS-demonstratie, gehouden in december 2005, was succesvol. We konden een door mensen gedragen AR-systeem demonstreren waarmee een DARTS-gebruiker kon communiceren met een virtuele ICV die werd gepresenteerd in de DARTS HMD. De gebruiker kon de virtuele ICV in de real-world, real-time omgeving vanuit verschillende gezichtspunten bekijken. De DARTS-gebruiker kon ook de virtuele ICV-beweging in de real-world, real-time omgeving bekijken. Een samenvatting van de componenten die ons hebben geholpen deze prestatie te realiseren, wordt hier samengevat:

Tweeweg DIS-interface:We hebben software ontwikkeld om DIS Protocol Data Units (PDU's) van een netwerkverbinding te ontvangen en te decoderen, en ook om DIS PDU te coderen en te verzendenS. We hebben code ontwikkeld om de positie en oriëntatie van entiteiten om te zetten tussen het wereldcoördinatenframe dat wordt gebruikt door het ICV-testbed naar een lokaal coördinatenframe dat wordt gebruikt door DARTS.

Virtuele entiteitscontrole:We integreerden onze DIS PDU-communicatiesoftware in DARTS, zodat we de positie- en oriëntatiecoördinaten van een inkomende PDU konden gebruiken om de positie van een virtueel object ten opzichte van de DARTS-entiteit te bepalen. We hebben ook code ontwikkeld om de lokale positie van de DARTS-entiteit om te zetten in wereldcoördinaten en die coördinaten naar een uitgaande DIS PDU te sturen. We hebben een eerste DIS-interface met de ICV-simulator ontwikkeld en gedemonstreerd, waardoor virtuele en live-entiteiten met elkaar konden communiceren en een niet-gekoppelde gebruiker een virtuele entiteit in een real-world, real-time weergave kon zien.

Draadloze positiebepaling:We hebben software ontwikkeld om toegang te krijgen tot het Ubisense draadloze positievolgsysteem en meerdere keren per seconde positie-updates te verkrijgen. Deze positiegegevens worden gebruikt om het DARTS-systeem in staat te stellen te bepalen waar het zich ten opzichte van de wereld bevindt, zodat we kunnen bepalen hoe een virtuele entiteit moet worden weergegeven in het DARTS-systeem en hoe de DARTS-gebruiker moet worden weergegeven in de virtuele wereld van het ICV Testbed wordt weergegeven. Deze mogelijkheid werd gebruikt om vroege demonstraties mogelijk te maken, terwijl we onze algoritmen voor het volgen van objectieve punten en herstel van poses ontwikkelen waarvoor geen extra infrastructuur nodig is naast de uitrusting die door de soldaat wordt gedragen. Deze nieuwe algoritmen voor het herstellen van poses zullen uiteindelijk de plaatsbepalingsgegevens van het UbiSense-systeem vervangen (wanneer er geld beschikbaar komt om dit onderzoek voort te zetten). Het UbiSense-systeem wordt ook gebruikt voor DARTS-systeemtesten om de nauwkeurigheid van onze pose-herstelalgoritmen te valideren.

OLED-gebaseerde HMD:We hebben een monoculaire OLED-gebaseerde HMD in het systeem geïntegreerd om het nut van de OLED-schermen te verifiëren om gedemonteerde training te ondersteunen. De HMD zorgde voor voldoende getrouwheid in een monoculaire weergave. We konden samenwerken met op OLED gebaseerde HMD-fabrikanten zoals Liteye en ICUITI om een conceptueel ontwerp voor een verrekijkersysteem te ontwikkelen. Op dit moment biedt OLED-technologie het beste potentieel voor de ontwikkeling van HMD-oplossingen die voldoende zijn om gedemonteerde training te ondersteunen en goedkoop genoeg om in de grote hoeveelheden te worden gekocht die nodig zouden zijn als deze trainingstechnologie door het Amerikaanse leger zou worden overgenomen.

Draadloos tv-transmissiesysteem voor demonstratieondersteuning:We hebben verschillende beeldtransmissiesystemen geëvalueerd en verschillende optionele systemen geïmplementeerd om het beeld dat voor de DARTS-gebruiker wordt geproduceerd, beschikbaar te maken voor andere waarnemers in de buurt.

Ontwikkeling van algoritmen voor het volgen van punten en het herstellen van poses:We hebben een algoritme voor het volgen van punten geïmplementeerd met behulp van de MATLAB-softwareomgeving die punten kan volgen via een reeks afbeeldingen. Dit algoritme vindt punten uit verschillende delen van het videobeeld, met behulp van een algoritme dat gemakkelijk te volgen punten identificeert. Zodra het algoritme deze gemakkelijk te volgen punten heeft geïdentificeerd, zoekt het naar een match voor elk van deze punten in opeenvolgende afbeeldingen. Deze punten worden gebruikt om de positie en oriëntatie van de DARTS-gebruiker te bepalen ten opzichte van real-world objecten en virtuele entiteiten in de omgeving. We hadden gehoopt het verbeterde algoritme in deze fase te integreren, maar konden dit niet doen vanwege de inspanning die het kostte om het algoritme te maken. We hebben het algoritme echter kunnen demonstreren en valideren met behulp van videoclips die zijn verkregen van de STTC-demonstratiesite. De volgende paragrafen geven een overzicht van het pose-tracking-algoritme dat voor deze inspanning is ontwikkeld.

Om een virtueel object zo weer te geven dat het de echte wereld correct overlapt, moeten we een zeer nauwkeurige schatting hebben van de richting waarin de helm wijst. We moeten dit van moment tot moment volgen terwijl de DARTS-gebruiker zich verplaatst, en dat doen we met de grootst mogelijke precisie. Als het hoofd van de gebruiker niet precies wordt gevolgd terwijl het beweegt, lijkt het virtuele object op een onrealistische manier te verschuiven ten opzichte van de echte wereld. Bovendien kunnen zich kleine positiefouten ophopen totdat het systeem volledig verloren gaat. Als een virtueel object zich bijvoorbeeld precies 10 meter ten zuiden van de positie van de gebruiker moet bevinden, dan moet dat object in het midden van het gezichtsveld van de gebruiker staan als de gebruiker naar het zuiden kijkt. Als het systeem de oriëntatie van de gebruiker uit het oog verliest, kan het het object niet weergeven wanneer de gebruiker in de juiste richting kijkt. In plaats daarvan kan het object naar het oosten of het westen worden weergegeven. Het kan zelfs lijken alsof het virtuele object rond de gebruiker draait.

Voor onze basisinspanning hebben we een draadloze positiesensor en een traagheidspositiesensor gebruikt om de positie en oriëntatie van de DARTS-helm te volgen. Deze sensoren leveren redelijk nauwkeurige gegevens, maar ze hebben niet de precisie die nodig is om een zeer realistische positionering van virtuele objecten ten opzichte van een echt wereldbeeld mogelijk te maken. Naast het gebrek aan precisie had elke sensor zwakke punten waardoor ze onder bepaalde omstandigheden valse gegevens konden verstrekken. Ons doel is om het stereovisiesysteem te gebruiken om de positie van de helm beter te kunnen volgen, door de verandering in de videobeelden te meten terwijl de helm beweegt, en vervolgens de stereovisie-trackinggegevens te combineren met de andere sensorgegevens om de beste schatting van de positie van de helm die we kunnen.

Een mens die naar een videobeeld kijkt, kan intuïtief de beweging van de videocamera bepalen aan de hand van de manier waarop de videobeelden bewegen. Als de camera bijvoorbeeld naar rechts draait, verwachten we dat objecten in het videobeeld naar links bewegen. Als de camera naar voren beweegt, worden objecten in het midden van het beeld groter, en objecten aan de boven-, onder- of zijkanten van het beeld bewegen weg van het midden en naar de rand van het beeld. Als we de camera ondersteboven draaien, draait het beeld ook ondersteboven. Als we een computerprogramma gebruiken om punten in een reeks videobeelden te volgen en stereovisie gebruiken om de 3D-positie van deze punten ten opzichte van de bewegende camera te berekenen, dan kunnen we de puntvolginformatie gebruiken om de beweging van de camera te berekenen, net zoals een mens intuïtief doet. Als we deze volgpunten kunnen volgen en hun positie kunnen bepalen met een hoge mate van precisie en nauwkeurigheid, dan kunnen we ook de positie van de helm volgen met een hogere mate van precisie en nauwkeurigheid dan mogelijk is met onze traagheidssensor of onze draadloze positiesensor .

Om de positie van een punt ten opzichte van een bewegende camera te volgen, moeten we een paar stereocamera's gebruiken en het punt in beide camerabeelden volgen. Eerst moeten we het punt tussen de linker- en rechterbeelden matchen, zodat we de positie van het punt kunnen bepalen, daarna moeten we dat punt volgen via een reeks beelden van beide camera's, zodat we de beweging van het punt kunnen bepalen. Over het algemeen is het voor een computerprogramma niet eenvoudig om overeenkomende punten in een paar afbeeldingen te vinden, maar sommige punten zijn gemakkelijker te volgen dan andere. Om het beste algoritme voor het volgen van punten te ontwikkelen, hebben we een manier nodig om punten te identificeren die gemakkelijk te volgen zijn, en we hebben een manier nodig om valse overeenkomsten zoveel mogelijk te elimineren, terwijl we goede punten zo lang mogelijk volgen.

We matchen punten door het gebied rond een punt in elke afbeelding te vergelijken en hun overeenkomst te berekenen. Als het gebied rond een punt in de ene afbeelding bijna identiek is aan het gebied rond het punt in de andere afbeelding, kunnen we concluderen dat de punten overeenkomen. Als we er zeker van willen zijn dat we alleen de beste matches gebruiken voor het bijhouden van punten, dan kunnen we alleen matches accepteren die de beste overeenkomstenscores hebben. Deze benadering geeft ons echter niet de mogelijkheid om punten te volgen door een lange reeks beelden terwijl de camera beweegt, en het geeft ons geen goed vermogen om punten te herkennen die we al eerder hebben gevolgd. Naarmate de camera beweegt, verandert het uiterlijk van een volgpunt. Het gebied rond een punt kan groter worden als de camera ernaartoe beweegt, of het gebied rond een punt kan roteren als de camera wordt gedraaid. Eenvoudige algoritmen voor het matchen van punten kunnen geen rekening houden met dit soort wijzigingen, dus laten ze een lagere gelijkenisscore zien, waardoor het punt wordt afgewezen. We hebben een manier nodig om een punt dat we hebben gevolgd te herkennen, zelfs als we het vanuit een andere hoek bekijken, zodat we goede punten kunnen volgen zolang ze in zicht blijven, en eerder gevolgde punten kunnen herkennen als ze weer in zicht komen. Als we dit niveau van puntenvolging op de lange termijn kunnen bereiken, kunnen we de positie van de DARTS-helm gedurende langere tijd nauwkeurig volgen. Ons doel is om een verscheidenheid aan geavanceerde beeldverwerkingstechnieken te combineren om dit soort puntvolging te bereiken.

We hebben verschillende testprogramma's ontwikkeld die ons naar dit doel brengen. De eerste stap is het herkennen van punten vanuit verschillende hoeken. Als we bijvoorbeeld beginnen met het volgen van een punt en het volgen door een bewegende reeks van 100 beelden, willen we het punt van het laatste beeld kunnen vergelijken en zien dat het nog steeds overeenkomt met het punt van het eerste beeld. Een beeldverwerkingstechniek die een affiene transformatie wordt genoemd, kan de verandering in uiterlijk van een punt modelleren wanneer het vanuit verschillende hoeken wordt bekeken. Als we een affiene transformatie kunnen vinden die het startpunt verandert zodat het eruitziet zoals het zou zijn vanuit de uiteindelijke kijkhoek, dan zouden de punten er hetzelfde uit moeten zien. Wanneer we de overeenkomst tussen het getransformeerde beginpunt en het laatste punt berekenen, zouden we een zeer goede matchscore moeten kunnen krijgen, wat we niet zouden kunnen krijgen zonder de affiene transformatie toe te passen. We hebben een programma ontwikkeld dat deze techniek toepast en daarmee een aantal punten volgt door een reeks beelden van één camera.

Naast het volgen van punten door een reeks afbeeldingen, moeten we ook de punten tussen de linker- en rechtercamera's matchen. Hiermee kunnen we de afstand en hoek van de camera tot het punt bepalen. Naarmate de camera beweegt, veranderen deze afstand en hoek. Door de verandering in de afstand en hoek van een aantal punten te meten, kunnen we de beweging van de camera berekenen. We hebben code ontwikkeld die punten tussen een linker- en rechtercamera matcht en die punten vervolgens van het ene beeld naar het andere volgt.

We zullen de functionaliteit van het positietrackingprogramma combineren met de functionaliteit van het programma dat veranderingen in kijkhoek compenseert. Als we deze programma's eenmaal hebben gecombineerd, zullen we in eerste instantie goed in staat zijn om punten over een aantal frames te volgen. De volgende stap is het ontwikkelen van Kalman-filters die de luidruchtige gegevens die we ontvangen van de draadloze positietracker, de traagheidspositietracker en het puntvolgsysteem zullen verfijnen. Elke lezing van elke gegevensbron zal de neiging hebben om een fout te bevatten, en elke gegevensbron zal enigszins afwijken van de andere gegevensbronnen. Een Kalman-filter is een techniek voor het combineren van ruisige gegevens uit meerdere gegevensbronnen om een optimale schatting te geven van de waarde die wordt gemeten. In ons geval geeft het Kalman-filter een optimale schatting van de positie en oriëntatie van de DARTS-helm, met nieuwe bijgewerkte schattingen bij elke nieuwe sensormeting. Het gecombineerde systeem, met verbeterde point-tracking vanuit stereovisie en Kalman-filtering om meerdere gegevensbronnen te combineren en glad te strijken, zal de prestaties van het DARTS-systeem aanzienlijk verbeteren.

Samenvatting van bevindingen voor het DARTS-programma

Hier vatten we de belangrijkste bevindingen van deze inspanning samen:

-

We ontdekten dat draagbare, gedemonteerde AR haalbaar is

-

We waren in staat om de omgeving rond de AR-gebruiker te voelen om de gegevens te verzamelen die nodig zijn om virtuele objecten correct weer te geven

-

We demonstreerden real-time occultatie van virtuele objecten (virtueel en dynamisch) door echte objecten

-

We waren in staat om een virtueel object correct weer te geven terwijl de gebruiker in positie en oriëntatie rond het virtuele object bewoog

-

We waren in staat om de verwerkings- en stroombehoeften van het systeem in een door mensen gedragen configuratie op te vangen

-

Efficiënte software kan AR succesvol laten werken met minder verwerkingsvereisten om real-time werking mogelijk te maken zonder buitensporige apparatuurvereisten

-

Stereovisiegegevens kunnen worden gebruikt om de nodige omgevingsgegevens te verzamelen.

-

Geavanceerde computervisietechnieken kunnen zorgen voor meer getrouwheid van stereovisiegegevens

-

Verbetering van het hardware-ontwerp voor DARTS is nodig om het gebruiksgemak van het systeem te vergroten

-

DARTS zal in de nabije toekomst kunnen werken op draagbare computersystemen zoals de Quantum 3D Thermite

-

Doorzichtige beeldschermen op het hoofd, waarschijnlijk gebaseerd op OLED-technologie, zullen in de nabije toekomst een acceptabel niveau van zichtbaarheid en detail bieden

-

Een herbruikbare softwarearchitectuur kan worden aangepast en hergebruikt met verschillende sensorsuites, afhankelijk van de toepassingsklasse (wapen, voertuig, door mensen gedragen systeem)

Augmented Reality aan het werk voor de Warfighter

De volgende paar afbeeldingen zijn misschien wel de beste manier om het potentieel van AR voor de Warfighter te laten zien:

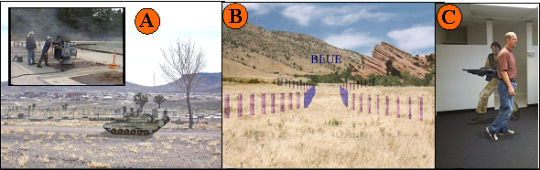

Op de afbeeldingen hierboven, item A toont een virtuele vijandelijke tank ingebed in een echte wereldscène. We hebben vergelijkbare AR-doelen voorzien in ons Virtual Target Gunnery System dat wapens ondersteunt, zoals het Mark 38 machinegeweer (zie inzet bij item A) met de mogelijkheid om dynamische doelen aan te vallen met levend vuur of droog vuur.

Artikel B toont het gebruik van AR om commando- en besturingsafbeeldingen aan de gebruiker te presenteren, ingebed in hun real-world, realtime weergave. Deze door mijnen gearchiveerde inbreuk wordt aan een bestuurder van een militair platform getoond via een systeem dat het Glass Turret Visualization System wordt genoemd en dat tussen 2000-2003 door ons bedrijf is ontwikkeld.

Artikel C presenteert een weergave van een virtuele tegenkracht die dynamisch wordt afgesloten door een persoon die voor de virtuele entiteit loopt. Dit is een weergave van het DARTS-systeem dat in dit artikel wordt beschreven.

Gebieden die extra inspanning vereisen

Aan het einde van deze inspanning hebben we de staat van het DARTS-demonstratiesysteem beoordeeld en verschillende items geïdentificeerd die in toekomstig DARTS-onderzoek moeten worden aangepakt:

Integratie van op OLED gebaseerde verrekijker HMD: Nu we hebben vastgesteld dat er enkele betaalbare HMD-systemen op de markt zijn die kunnen worden gebruikt om gedemonteerde AR te ondersteunen, willen we een van deze in ons DARTS-systeem integreren.

Integrated Helmet Sensor Suite: de DARTS-inspanning is een relatief kleine onderzoeks- en ontwikkelingsinspanning. Daarom doen we er alles aan om contractmiddelen alleen te besteden aan die inspanningen die de state-of-the-art in AR verbeteren. De huidige staat van de helm is echter niet aantrekkelijk en moet mogelijk worden verfijnd voordat deze wordt gebruikt in een grote openbare demonstratie.

Gebieden die aanvullend onderzoek vereisen

In onze basisinspanning hebben we drie gebieden geïdentificeerd die aanvullende verbetering behoeven om ons doel van een geloofwaardig en draagbaar AR-systeem te bereiken. Deze gebieden zijn:

Verbeterde realtime occultatie — In de Base-inspanning waren we in staat onze occultatie te verbeteren door ons scancamerasysteem te vervangen door een camerasysteem dat een volledig beeld in één enkel moment vastlegt. Dit stelt ons in staat om wat we het "treineffect" in onze occultatiegegevens zullen noemen, te elimineren. Wanneer de scancamera's een afbeelding verzamelen terwijl de gebruiker zijn hoofd heen en weer beweegt, zorgt de beweging van links naar rechts ervoor dat pixels aan de onderkant van de afbeelding later worden vastgelegd dan die aan de bovenkant van de afbeelding. Deze vertraagde opname van pixels kan ervoor zorgen dat objecten worden vervormd, zodat het onderste deel van het object naar de zijkant lijkt te lopen (de vervorming lijkt op de sleep op een bruidsjurk of andere zeer formele jurk - vandaar onze naam voor de effect). Het tweede effect om voor te corrigeren is het halo-effect rond objecten. Dit wordt veroorzaakt doordat CPU-beperkingen ons niet toelaten om elke pixel in een paar afbeeldingen te samplen. We hebben een algoritme ontwikkeld om dit effect, dat we de "deformable windows-benadering" noemen, aanzienlijk te verminderen (hopelijk te elimineren). Dit wordt kort beschreven in de volgende sectie.

Gedistribueerde parallelle verwerking — Integreer onderzoek naar parallelle verwerking op grafische verwerkingseenheden (GPU's) om het CPU-gebruik te optimaliseren en de hardwarevereisten te minimaliseren.

Verbeterde positiebepaling/positieherstel — Verminder of elimineer de afhankelijkheid van draadloze positionering. Integreer het in deze fase ontwikkelde verbeterde puntvolgalgoritme in het demonstratiesysteem.

Vervormbare ramen voor verbeterde occultatie

Met stereovisie vinden we de afstand tot een punt door dat punt in twee naast elkaar liggende afbeeldingen te vinden en de verschuiving van het punt van het ene beeld naar het andere te meten. Om te bepalen welke pixel in de rechterafbeelding overeenkomt met een pixel in de linkerafbeelding, nemen we een venster met pixels rond het punt in de linkerafbeelding en vergelijken de pixelwaarden in dat venster met de vensters rond een set van pixels uit de rechter afbeelding. We kiezen de pixel in de rechter afbeelding waarvan het venster het beste past bij het venster rond de pixel in de linker afbeelding. Om deze techniek goed te laten werken, moeten de vensters rond elke pixel een goede textuur hebben en moeten ze een gebied beslaan met dezelfde diepte door het hele venster. Wanneer een venster zich over een gebied van een afbeelding met twee verschillende diepten uitstrekt, heeft dit de neiging een vaag resultaat te produceren, waardoor het voor het stereovisieprogramma moeilijk is om de diepte correct te bepalen. Vanwege dit probleem doen de meeste stereovisiesystemen het slecht om de randen tussen een nabijgelegen object en de achtergrond correct te lokaliseren.

Een benadering die recentelijk is uitgeprobeerd door stereovisie-onderzoekers is het gebruik van vervormbare matchvensters. Het is gebruikelijk om overeenkomstvensters te gebruiken die gecentreerd zijn op de pixels die worden vergeleken, maar het is theoretisch net zo geldig om vensters te gebruiken die niet gecentreerd zijn op hun pixels. Onderstaande afbeeldingen demonstreren dit concept. We beginnen met een paar afbeeldingen van de UCF-IST-parkeerplaats. Let op de witte vrachtwagen op de voorgrond. Zijn positie is verschoven tussen het linkerbeeld en het rechterbeeld. We kunnen de afstand tot de vrachtwagen vinden door punten tussen de afbeeldingen te matchen. Als we echter naar de geselecteerde ramen aan de achterkant van de vrachtwagen kijken, kunnen we zien dat de helft van elk raam zich boven de vrachtwagen bevindt en de andere helft over een verder afgelegen achtergrondgebied. De geselecteerde punten in het midden van elk venster maken in feite deel uit van de achtergrond en maken geen deel uit van de vrachtwagen, dus een stereovisiesysteem zou moeten bepalen dat dit punt verder weg is dan de vrachtwagen. Een stereovisiesysteem dat gebruikmaakt van vergelijkingsvensters als dit, zou echter waarschijnlijk berekenen dat dit punt zich op dezelfde afstand als de vrachtwagen bevindt.

Als we een typisch stereovisiesysteem op dit paar afbeeldingen gebruiken, zou het waarschijnlijk de juiste afstand tot de vrachtwagen vinden, maar het zou ook een valse afstandshalo rond de vrachtwagen creëren. In deze halo met valse afstand zouden de verder verwijderde achtergrondpixels ten onrechte worden gerapporteerd als dezelfde afstand als de minder verre vrachtwagen. Deze halo heeft de helft tot tweederde van de breedte van ons vergelijkingsvenster. We kunnen proberen een kleiner vergelijkingsvenster te gebruiken om dit effect te verminderen, maar dit veroorzaakt meer valse overeenkomsten omdat een klein venster niet zoveel beeldtextuur kan vastleggen. Een betere oplossing is om vensters te gebruiken die zich niet over een afstandsgrens uitstrekken. In de onderstaande afbeeldingen vergelijken we vensters rond hetzelfde punt als voorheen, maar nu zijn de vensters opzij geschoven, zodat ze grotendeels de achtergrond bedekken. Ramen zoals deze zullen eerder vaststellen dat dit punt deel uitmaakt van de achtergrond en geen deel uitmaakt van de vrachtwagen.

Om deze benadering in een stereovisiesysteem toe te passen, moeten we een manier hebben om te bepalen wanneer een punt zich in de buurt van een rand bevindt waar afstanden plotseling veranderen, en we moeten kunnen bepalen op welke manier het venster moet worden verschoven zodat het een gebied dat zich meestal op de achtergrond bevindt, of meestal op het dichtstbijzijnde object. We beginnen met het vergelijken van alle pixels in de afbeelding met behulp van de standaardbenadering, waarbij vensters worden vergeleken die zijn gecentreerd op de pixels die worden gematcht. Vervolgens zoekt het programma door het beeld naar gebieden waar de afstand plotseling verandert. Op dit punt gaan we ervan uit dat we de echte rand waar de afstand verandert niet hebben gevonden en we zullen die rand van beide kanten benaderen met verschoven vensters. We zouden een correcte afstand moeten kunnen vinden voor veel pixels die voorheen foutieve resultaten hadden. Met deze aanpak kunnen we valse overeenkomsten langs de randen niet elimineren, maar hopelijk kunnen we een aanzienlijke verbetering aanbrengen.

Onderzoekers van computervisie hebben de afgelopen 20 jaar een aantal van dit soort technieken uitgeprobeerd om de kwaliteit van de resultaten van stereovisie te verbeteren. In de meeste gevallen hebben ze enig voordeel kunnen laten zien, maar ze hebben vaak geconstateerd dat de computerkosten erg hoog zijn. Naarmate computers steeds sneller worden, bereiken we een punt waarop het mogelijk is om verschillende verfijningsstappen te gebruiken om fouten te corrigeren die optreden bij verschillende soorten afbeeldingen. Deze benadering met vervormbare vensters is een van de vele die we willen evalueren. We hopen verschillende van de meest veelbelovende benaderingen te combineren om een hoog niveau van algehele nauwkeurigheid en robuustheid te bereiken.

Geleerde lessen in het DARTS-programma

Hier presenteren we de lessen die we in de loop van dit onderzoek hebben geleerd.

We ontdekten dat onze sensorset, die de draadloze positiesensor, de traagheidspositiesensor en de stereovisiecamera's omvat, ons de onbewerkte gegevens kan leveren die we nodig hebben om effectieve AR te bereiken. Onze software zal succesvol kunnen presteren zonder dat er andere sensoringangen nodig zijn.

We ontdekten dat het toevoegen van de mogelijkheid om te bewegen met het DARTS-systeem en de mogelijkheid om verbinding te maken met andere simulators met behulp van een DIS-interface, de complexiteit aanzienlijk verhoogde, wat een uitgebreide integratietest vereiste.

We ontdekten dat we op de hoogte moesten zijn van unieke definities van coördinatenstelsels. Ons kern-DARTS-systeem heeft een intern coördinatensysteem, zodat de positie van virtuele objecten kan worden gerelateerd aan de positie van de DARTS-gebruiker. Toen we verschillende functies en mogelijkheden aan het systeem toevoegden, kwamen we verschillende unieke coördinatensysteemdefinities tegen, waarvoor coördinatenconversies nodig waren om compatibiliteit te bereiken. Deze coördinaatconversies zijn erg moeilijk te visualiseren op basis van alleen wiskundige formules, zodat we er niet zeker van konden zijn dat onze conversie correct was totdat we de visuele uitvoer van het DARTS-systeem konden testen om te bevestigen dat virtuele objecten werden weergegeven en verplaatst zoals verwacht. Een van de belangrijkste taken die we moesten volbrengen om het DARTS-systeem te integreren met de ICV voor onze demonstratie bij STTC, was om het uiterlijk van onze DARTS-entiteit op de schermen van de ICV visueel te testen en de conversieparameters aan te passen totdat de virtuele entiteit hetzelfde bewoog op het scherm terwijl de DARTS-gebruiker in werkelijkheid bewoog.

We ontdekten dat de geloofwaardigheid van een virtueel object in AR sterk wordt beïnvloed door de kwaliteit van de gebruikte 3D-modellen. Het is belangrijk om zeer gedetailleerde modellen voor virtuele objecten te gebruiken en om realistische visuele aanwijzingen zoals verlichting en schaduwen toe te voegen om het virtuele object er meer uit te laten zien alsof het op een bepaalde positie in de echte ruimte bestaat. De modellen die voor typische simulaties worden gebruikt, hebben over het algemeen een laag detailniveau. Deze modellen zijn goed genoeg in een simulatieomgeving, omdat ze meestal ver weg op het scherm verschijnen en omdat de hele simulatie er kunstmatig uitziet. Wanneer virtuele objecten echter worden bekeken tegen een echte scène, hebben ze meer realisme nodig om een goede geloofwaardigheid te bereiken.

De stroomvereisten moeten hardware omvatten voor demonstratie-ondersteuning vooraf. In ons ontwikkelingsproces hadden we in eerste instantie stroom nodig voor onze laptop, videocamera's en traagheidspositiesensor. Omdat we extra componenten hebben toegevoegd om ons in staat te stellen een uitvoerbeeld te verzenden voor demonstratiedoeleinden, merkten we dat we meerdere spanningen moesten leveren met behulp van meerdere batterijpakketten. Om plaats te bieden aan alle componenten en bedrading, hebben we verschillende configuraties doorlopen terwijl we verschillende functies hebben gewijzigd. We hebben vastgesteld dat we vanaf het begin rekening moeten houden met al onze systeemvereisten wanneer we verdere wijzigingen aan het systeem aanbrengen.

Hardware moet robuust zijn om ontwikkeling te ondersteunen. We hadden een aantal problemen tijdens de ontwikkeling van het systeem vanwege gevoelige, delicate componenten die goed werkten op een testbank, maar slecht werkten bij gebruik van het systeem in een draagbare, mobiele configuratie. We hebben geconstateerd dat het nodig is om samen te werken met leveranciers van onderdelen om robuuste onderdelen te vinden en er vervolgens voor te zorgen dat onze montage- en bedradingsarrangementen maximale stabiliteit tijdens mobiel gebruik mogelijk maakten.

Vroege end-to-end operatie is een noodzaak om ontwikkeling te stimuleren. Ons ontwikkelingsproces vereiste dat we verschillende discrete mogelijkheden moesten realiseren, zoals een DIS-interface of integratie van ons draadloze positioneringssysteem. We waren niet in staat om volledige end-to-end mobiele tests uit te voeren totdat al deze functies of subsystemen waren geïmplementeerd. We ontdekten dat, hoewel onze subsystemen allemaal afzonderlijk werkten, en hoewel het systeem goed werkte op de testbank, er onvoorziene problemen waren bij het bedienen van het systeem in een door de mens gedragen, mobiele configuratie. We hebben vastgesteld dat het belangrijk is om een end-to-end systeem zo snel mogelijk werkend te krijgen, zodat onverwachte problemen kunnen worden ontdekt en opgelost.

We ontdekten dat ons draadloze positioneringssysteem positiegegevens kan leveren met een relatief klein foutpercentage, maar toen we het volledige DARTS-systeem buitenshuis testten in een mobiele configuratie, waren er frequente onderbrekingen van het draadloze signaal dat werd gebruikt om de positie te bepalen. We concludeerden dat signaalonderbrekingen zoals deze waarschijnlijk veel voorkomen in een typisch DARTS-trainingsscenario, dus we zullen ons best doen om onze afhankelijkheid van externe positioneringsgegevens te minimaliseren. We hopen deze gegevens hoogstens als incidenteel referentiepunt te gebruiken om ervoor te zorgen dat onze continue schatting van de positie nauwkeurig blijft.

Het accommoderen van vrij verkeer is haalbaar, maar moeilijk. We ontdekten dat het bedienen van het systeem op de testbank veel gemakkelijker was dan het bedienen van het systeem in een door mensen gedragen, mobiele configuratie. Componenten en bedradingsverbindingen die goed werkten op de testbank, zorgden ervoor dat onze computer vastliep toen we probeerden het systeem te dragen. We moesten componenten vervangen, opnieuw monteren of opnieuw bedraden om hun stabiliteit te verbeteren. We ontdekten ook dat sensorgegevens dubbelzinniger zijn wanneer we ons verplaatsen, waardoor we onze software zorgvuldig moesten afstemmen om acceptabele resultaten te leveren. Een van de belangrijkste doelen van onze follow-up zal zijn om het systeem in staat te stellen kleine veranderingen in de configuratie van de sensoren te compenseren zonder prestatieverlies.

De potentiële voordelen van AR voor de Warfighter

We hebben de volgende toepassingen van AR geïdentificeerd om te voldoen aan militaire trainingsvereisten:

DOELEN — De behoeften van de oorlogsjager vereisen de creatie van een nieuwe generatie afstandsdoelen. Deze nieuwe generatie doelen moet een breed spectrum van bevriende, vijandige en neutrale platforms/individuen vertegenwoordigen om de voorbereidingen te ondersteunen die nodig zijn om te slagen in de complexe operationele omgeving van vandaag. Doelgroepen moeten in staat zijn te reageren op acties van cursisten en geloofwaardig complex gedrag te presenteren. Naast dit alles moeten toekomstige doelen waarneembaar zijn tijdens het werken in dag-, nacht- en verduisterde omstandigheden, evenals worden waargenomen door nachtkijkers of andere sensorsystemen. Het is duidelijk dat AR een redelijke kandidaat is om aan deze toekomstige vereisten te voldoen, aangezien AR-doelen kunnen worden gebruikt om live-vuur, FTX's en droogvuuroefeningen te ondersteunen zonder dat er een uitgebreide infrastructuur nodig is. AR-doelen kunnen worden ingebed in de systemen en apparatuur van de Warfighter.

COMMANDO & CONTROLE en OEFENING CONTROLE MAATREGELEN — De Combat Training Centres (CTC's) eisen dat eenheden complexe operaties uitvoeren onder observatie van CTC-personeel. Vaak moeten CTC-medewerkers zichzelf snel in de trainingsomgeving plaatsen om ervoor te zorgen dat eenheden adequaat en veilig worden opgeleid. Deze zelfde CTC-medewerkers kunnen zo dadelijk worden uitgezonden om de operaties van de eenheid te observeren. Het gebruik van AR om het uitvoeren van complexe trainingsmanoeuvres te helpen beheersen en de trainingsveiligheid te waarborgen, is een toepassing van AR die moet worden verbeterd.

NAADLOZE LIVE/VIRTUELE/CONSTRUCTIEVE INTEROPERATIE — Tegenwoordig worden de meeste grootschalige oefeningen niet langer uitsluitend op live-reeksen uitgevoerd. Grote oefeningen hebben meestal live/virtuele en constructieve trainingscomponenten die gelijktijdig worden uitgevoerd. Een opvallende tekortkoming van deze gecombineerde oefeningen is het onvermogen van de trainingskracht die in de Live-component van de oefening werkt om zijn virtuele of constructieve tegenhangers te zien. Dit gebrek aan naadloze werking wordt tegenwoordig verholpen door het invoegen van Observer/Controllers of uitgebreide workarounds die deze tekortkoming minimaliseren. Door krachten die actief zijn in het Live-domein te voorzien van een zicht op constructieve en virtuele entiteiten, zouden deze onrealistische tijdelijke oplossingen niet meer nodig zijn. Een dergelijke AR-oplossing zou het voor oefenplanners ook mogelijk maken om grotere tegenkracht of vriendelijke krachtcomponenten in oefeningen te injecteren om meer uitdagende training te presenteren.

SYSTEEMHERKENNING — De operaties van vandaag vereisen dat oorlogsvechters in staat zijn om snel bevriende, vijandige en neutrale troepen te identificeren. AR kan worden gebruikt op trainingslocaties en in het operatiegebied om systeemherkenningsvaardigheden aan te scherpen om de cyclustijden van beslissingen te verkorten en het potentieel van broedermoord te verminderen.

NA ACTIE BEOORDELING ANIMATIE — Nadat een eenheid een manoeuvre heeft voltooid, kan AR worden gebruikt om eenheidsleden door hun manoeuvre te laten lopen en hun beslissingen en acties op kritieke punten te onderzoeken. Deze scène-animaties kunnen met latere eenheden worden gebruikt om te laten zien hoe eerdere eenheden de manoeuvres hebben uitgevoerd. Dit kan een bijzondere waarde zijn bij operaties van kleine eenheden die verband houden met stedelijke gevechten.

PRESENTATIE VAN VEILIGHEIDSINFORMATIE — Wanneer er live-vuuroefeningen worden uitgevoerd, bestaat altijd de mogelijkheid dat iemand gewond of gedood kan worden. AR kan worden gebruikt om de linker- en rechterbereiklimieten, bereikgrenzen, hot ranges en ranges die tijdelijk zijn gesloten totdat een wapenstoring of een ander probleem is opgelost, verder te versterken.

MISSIE REPETITIE — AR zou kunnen worden gebruikt om virtueel belangrijke elementen van het terrein te construeren voor aanstaande operaties. Hierdoor zouden eenheden meer realistische missierepetities kunnen uitvoeren om hun kans op missiesucces te vergroten. AR kan ook worden gebruikt om complexe 'wat als'-situaties te presenteren die kunnen worden gebruikt om het definitieve plan te verfijnen of onvoorziene situaties te helpen ontwikkelen als er zich problemen voordoen.

PRESENTATIE VAN OPERATIONEEL COMMANDO & CONTROLE — GRAPHICS — In het verleden hebben we AR gebruikt om operationele afbeeldingen in realtime op het werkelijke terrein te presenteren om het situationeel bewustzijn te vergroten. Het gebruik van AR in deze context zorgt ervoor dat aan operationele graphics kan worden voldaan in alle licht- en weersomstandigheden. Het vermindert ook de tijd die nodig is om beslissingen te nemen, omdat het de tijd elimineert die momenteel wordt gebruikt om de operationele afbeeldingen op kaarten te associëren door ze te integreren in de real-world, realtime weergave van de soldaat.

NAVIGATIE VOOR OPERATIES EN TRAINING — Net als de beschrijving in de vorige bullet, kan AR worden gebruikt om realtime navigatie-informatie te presenteren aan platformbestuurders en gedemonteerde soldaten.

VIRTUELE OBSTAKELMARKERING — De operatiekamers van vandaag zitten vol obstakels en gevaren die vermeden moeten worden. Vaak gaan markeringen die paden door of rond deze obstakels aangeven, verloren. Door weersomstandigheden kan het vaak voorkomen dat deze markeringen niet zichtbaar zijn. Het gebruik van AR om doorgangen door obstakels te markeren kan soldaten helpen redden door ze veilig rond of door barrières en obstakels te leiden.

TRAINING VOOR WAARNEMERS — Een van de eerste toepassingen voor militaire training die we identificeerden, was het gebruik van AR voor Forward Observer-training. In deze toepassing zou men doelen en virtuele krachten in het zicht van de voorwaartse waarnemer kunnen injecteren (via een zichtblok, wapenvizier, verrekijker of ander apparaat) en de voorwaartse waarnemer laten bepalen of de entiteit een doelwit is, en zo ja, hoe je dit het beste kunt vervolgen. Een dergelijk systeem zou van groot nut zijn voor artillerie-eenheden die zelden de vruchten van hun arbeid zien. Het standpunt van de voorwaartse waarnemer als een doelwit dat wordt vervolgd, kan worden vastgelegd of zelfs worden teruggestuurd naar de artillerie voor latere bespreking tijdens een After Action Review (AAR).

Conclusie

Elke dag die voorbijgaat, gaat LVC-integratie verder zonder een belangrijk onderdeel voor volledige integratie in de trainingsdomeinen - een mogelijkheid voor de live speler om te zien en te communiceren binnen de LVC geïntegreerde strijdruimte. Naarmate de technologie blijft verbeteren en vooruitgaan, moet het legerleiderschap het potentieel voor het gebruik van Augmented Reality-tools en -technieken en het vermogen van deze technologie om bestaande en toekomstige trainingssystemen aan te vullen, erkennen.

Een binnenkort te publiceren Augmented Technology Roadmap biedt trainingsleiderschap en technologiebeheer met opties voor het implementeren van augmented en mixed reality-oplossingen voor huidige en toekomstige trainings- en operationele vereisten. Hoewel de benaderingen voor technische oplossingen breed en gevarieerd zijn, zijn er enkele mogelijke 'out of the box'-oplossingen die zeer snel kunnen worden benut. Met wat verdere ontwikkeling kan het DARTS-systeem bijvoorbeeld worden voorbereid voor een demonstratie die wordt gesynchroniseerd met een aankomend of gepland trainingsexperiment. Mogelijk gebruikt in de rol van een voorwaartse waarnemer, zou het DARTS-systeem trainingsleiders voorzien van blootstelling aan Augmented Reality in een relevante omgeving. Bovendien zouden soldaten de kans krijgen om praktijkervaring op te doen, wat leidt tot waardevolle opmerkingen en andere input voor toekomstige ontwikkeling.

De weg vooruit

Adviseer trainings- en testgemeenschappen en leiderschap over de mogelijkheden en het potentieel van Augmented Reality.

Zoek hulp en goedkeuring van belanghebbenden.

AR-onderzoek opnemen in toekomstige Army Technology Objectives (ATO) EN Small Business Innovation Research (SBIR) onderwerpen; en de ontwikkeling voortzetten onder meerdere ATO's.

Demonstreer nuttige technologie aan leiders en generatoren van vereisten.

Plan voor en zet Augmented Reality-mogelijkheden om in bestaande en geplande acquisitieprogramma's.

Over de Auteurs

Frank Dean is momenteel hoofdonderzoeker en S&T-manager bij het Simulation & Training Technology Center (STTC), RDECOM, Orlando, Florida. Dhr. Dean beheert R&D-projecten met betrekking tot de verbetering van ervaringsleren en training van de Warfighter, door gebruik te maken van augmented en mixed reality-technologieën. Dhr. Dean heeft meer dan twintig jaar ervaring met verschillende acquisitie- en technologieprogramma's voor militaire wapensystemen. Voorafgaand aan zijn opdracht bij RDECOM leidde de heer Dean technische projecten voor de PEO Simulation, Training & Instrumentation (PEO STRI), inclusief de exploitatie en het onderhoud van het National Training Center Instrumentation System (NTCIS), Ft. Irwin, Californië. Dhr. Dean heeft een Bachelor of Science in Electrical Engineering (BSEE) van de Universiteit van Miami in 1982 en een Master of Engineering Management (MEM) van George Washington University in 1994.

Sheila Jaszlics is de president van Pathfinder Systems, Inc. en streeft sinds 1991 naar AR voor militaire training en operaties. Ze is co-auteur van een Amerikaans octrooi dat realtime injectie van virtuele entiteiten in realtime scènes beschrijft (Amerikaans octrooi 6.166.744).

Scot Sanders is afgestudeerd aan de Universiteit van Noord-Colorado. Hij werkt al enkele jaren bij Pathfinder Systems, Inc. en is een belangrijke ontwikkelaar van de basissysteemsoftware en hardware-interfaces die in alle AR-systemen van Pathfinder worden gebruikt. Bovendien is Scot de maker van de high-fidelity azimut- en hoogtesensorsuite die wordt gebruikt op alle AR-systemen van Pathfinder die live vuur ondersteunen voor door de bemanning bediende wapens. Hij is ook een ontwikkelaar van de Kalman-filtersoftware die wordt gebruikt om de gegevens te extraheren en glad te strijken die we ontvangen van de hybride sensorsuites die we in al onze systemen gebruiken.

Rick Stilson is afgestudeerd aan de Colorado School of Mines en is de auteur van veel van de poseherstelsoftware die in het kader van deze inspanning is ontwikkeld. Hij was ook verantwoordelijk voor een groot deel van de DARTS-systeemsoftware en de hardware van het volgsysteem. Als medewerker van Pathfinder Systems biedt hij expertise op alle technische gebieden die te maken hebben met stereovisie-algoritmen. Hij is de ingenieur die verantwoordelijk is voor de ontwikkeling van de "vervormbare vensters"-benadering van edge-finding die we zullen implementeren om de kwaliteit van onze realtime occultatiegegevens te verbeteren.